非線形最小二乗法(ひせんけいさいしょうにじょうほう、英: non-linear least squares)とは、観測データに対するカーブフィッティング手法の一つであり、最小二乗法を非線形なモデル関数に拡張したものである。非線形最小二乗法は、未知パラメータ(フィッティングパラメータ)を非線形の形で持つ関数モデルを用いて、観測データを記述すること、すなわち、データに最も当てはまりの良いフィッティングパラメータを推定することを目的とする。

最小二乗法の主張

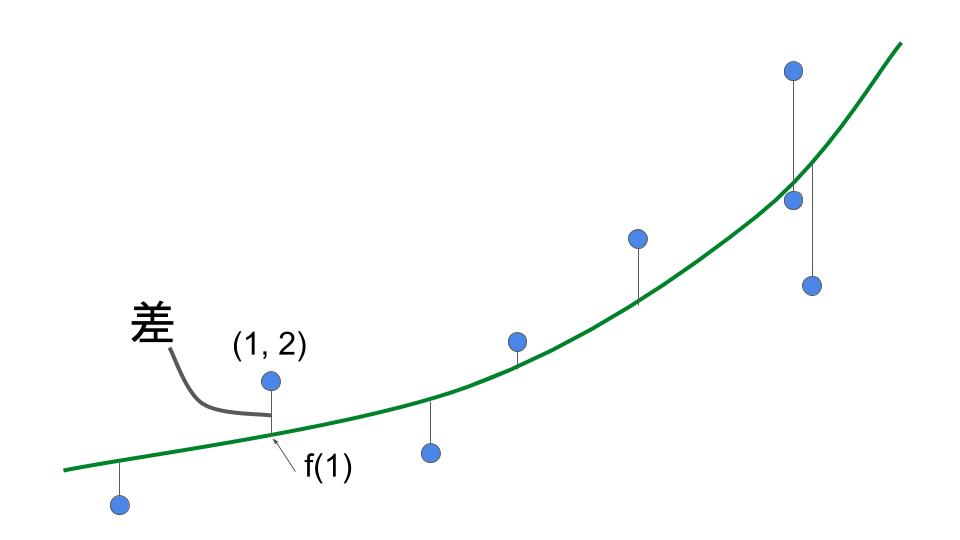

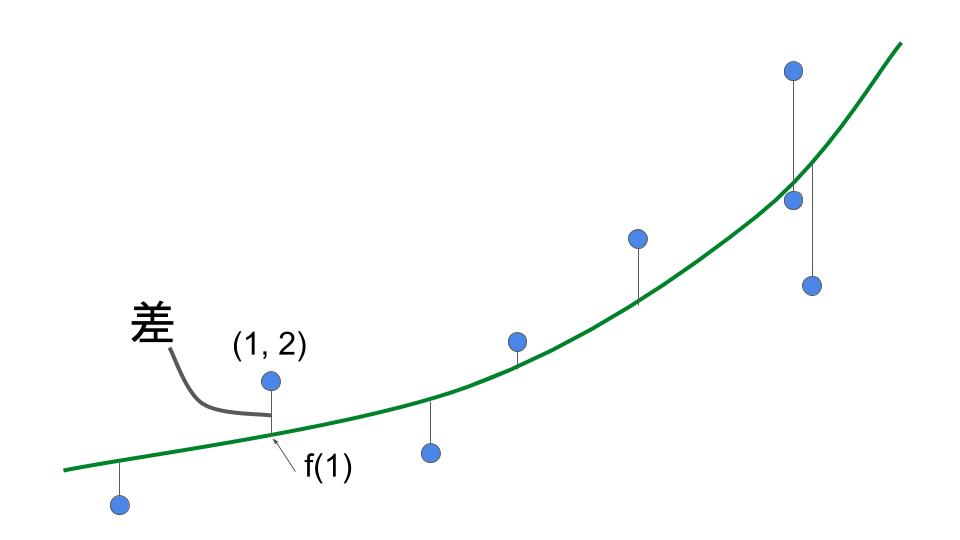

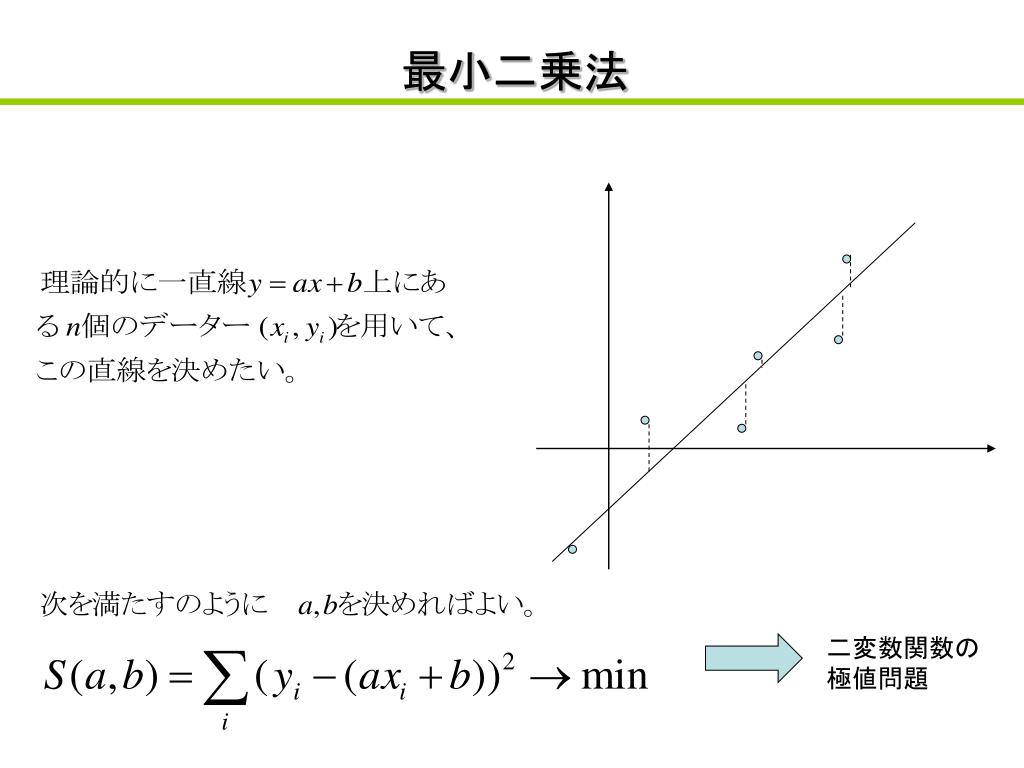

個のデータポイント からなるセットに対し、 個のフィッティングパラメータ を持つモデル関数

- (1-1)

をあてはめる場合を考える。ここで、それぞれのデータ において、 は説明変数とし、 は目的変数とする。 は、前記の 個のフィッティングパラメータ からなる実数ベクトルとする。

また、以下で定まる残差

- (1-2)

のそれぞれは、それぞれ、期待値 、標準偏差 の正規分布に従うとする。また、話を簡単にするため、 それぞれは、いずれも誤差を持たないとする。

このとき、考えるべき問題は、もっとも当てはまりのよい を見つけ出すことである。

非線形最小二乗法では、以下の残差平方和(より正確に言えば、標準化された残差平方和)

- (1-3)

を最小とするような が、もっとも当てはまりの良い を与えるフィッティングパラメータと考える。

この考え方は、数多ある考え方の一つに過ぎない。他の考え方としては、例えば

- を最小にする考え方

- を最小とする考え方(単に各データのバラつきが同じと勝手に仮定しただけ)。

- データ、モデル関数共に何らかの変換(例えば対数変換)を加えたうえで、最小二乗法をする考え方。

- カイ二乗値を最小にする考え方。

等があり得る。これらの考え方で”最適”となったフッティングパラメータは、最小二乗法では”最適”とは限らない。

ただし、最小二乗法の考え方は、確率論的に尤もらしさが裏付けられている。このことについては、次節にて論じる。

最小二乗法の尤もらしさ

最小二乗法は、正規分布に対応したフィッティングパラメータの最尤推定法である。ここでは最小二乗法の尤もらしさについて、確率論を援用して検討する。すなわち、残差 それぞれが、期待値 、標準偏差 の正規分布に従う確率変数であり、かつ、 からなる確率変数の族は、独立試行と考え、確率論を援用する。

仮定より、残差 それぞれは、いずれも、期待値 、標準偏差 の正規分布に従うため、あるデータセット において、その測定値が となる確率 は、

- (2-1)

となる。

今、データの測定は(数学的に言えば残差 それぞれが)独立試行と考えられるため、 個のデータポイントのセット が得られる確率 は、

- (2-2)

となる。ここで、は、連乗積を表す。

上式において、正規分布の単峰性より、確率 は、

- (2-3)

が最小(最も に近いとき)において、最大(最尤)となる。すなわち、最尤法の教えるところによれば、このとき、もっとも当てはまりがよいと考えるのが妥当だろうということになる。

勾配方程式への帰着

我々が考えるべき問題は、標準化された残差平方和

- (3-1)

を最小とするようなパラメータ を見つけることである。

このような において、 の勾配 grad は になる(必要条件)。したがって、このような は、以下の連立方程式の解となる。

- (3-2)

数値解法

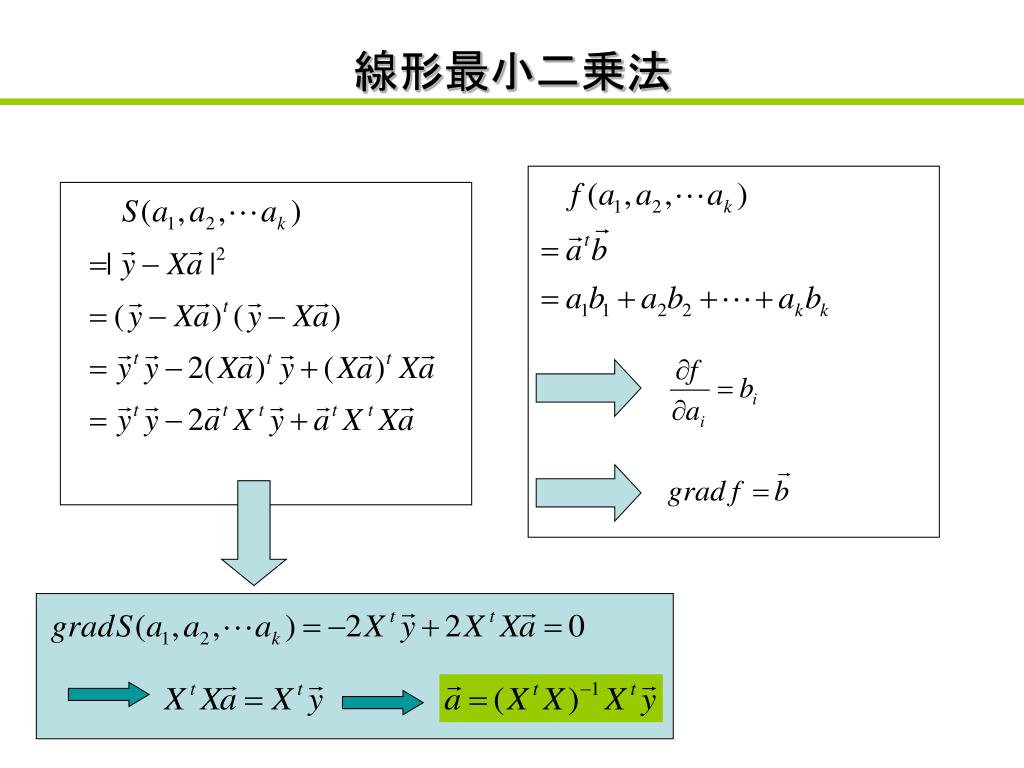

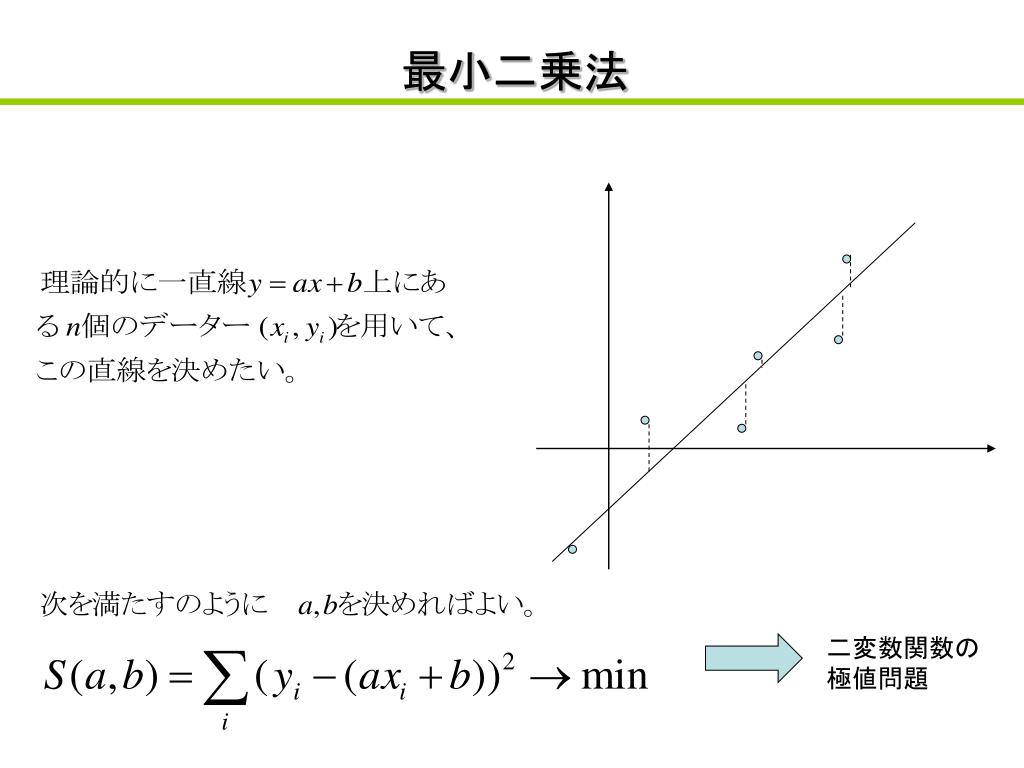

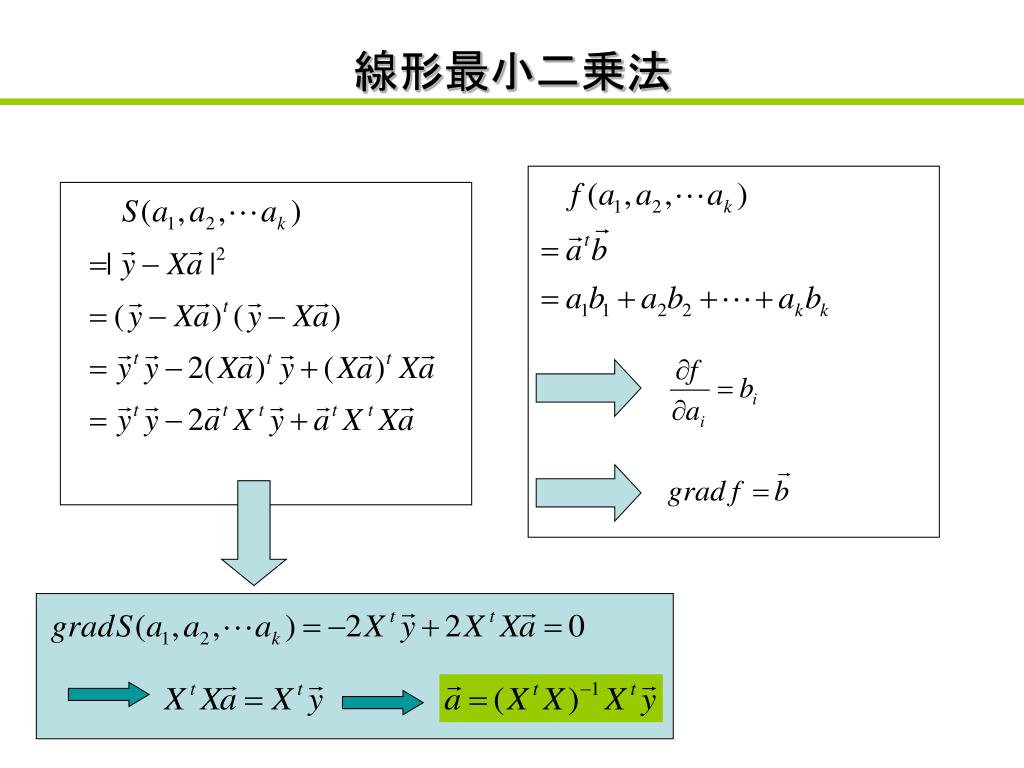

線形の最小二乗法では、式(3-2)は未知パラメータ についての連立一次方程式になるため、行列を用いて容易に解くことができるが、非線形最小二乗法では反復解法を用いる必要がある。解法には以下のような方法が知られている。

- 最急降下法

- ニュートン法

- ガウス・ニュートン法

- Marquardt法、修正Marquardt法

- パウエル(Powell)の最小二乗法、パウエルのハイブリッド法

脚注・参考文献

参考文献

脚注